Wszystko, co chcesz wiedzieć o BOTACH w obsłudze klienta

Pierwszy Impuls – dlaczego budujemy boty dla obsługi klienta

W SentiOne na co dzień – poza narzędziem do monitoringu internetu i angażowania się w dyskusje z internautami – pracujemy nad usprawnieniem komunikacji człowieka z rozumiejącymi naszą mowę “automatami”.

Kilkanaście miesięcy temu podjęliśmy wyzwanie budowy platformy wspierającej obsługę klientów online dla jednego z gigantów branży finansowej. Położyliśmy silny nacisk na automatyzację procesów sprzedażowych, optymalizację pracy i obsługi klienta w ramach Contact Center, windykacji, helpdesku pracowniczego i innych działów. Zmniejszyliśmy czas obsługi pojedynczego klienta dzięki wsparciu sztucznej inteligencji, pomagając uporać się z jeszcze większą liczbą zgłoszeń.

Bogatsi o doświadczenia z opisanego wdrożenia postanowiliśmy podzielić się wiedzą zebraną na przestrzeni ostatnich miesięcy.

Jak działa nasz system rozpoznawania mowy

Aby wrócić do klienta z wartościową informacją ze strony bota, na samym początku należy do perfekcji opracować jedną rzecz – dokładnie zrozumieć intencje zawarte w pytaniu. Dlatego właśnie stosowany przez nas moduł rozpoznawania mowy oparty jest na głębokim uczeniu sieci neuronowych i stanowi najnowocześniejsze rozwiązanie dostępne w komercyjnych konceptach. Jest to rozwiązanie typu Large-Vocabulary Continuous Speech Recognition (LVCSR). Brzmi skomplikowanie? Jednak jest to proste – chodzi o rozpoznawanie mowy swobodnej, czyli takiej, którą posługujemy się na co dzień, a nie tylko o ściśle określone formuły, jak bywało w przypadku botów pierwszej generacji.

Synteza mowy

Boty, nad którymi pracujemy, to nie tylko te najprostsze, które odpowiedzą Wam na Messengerze. Dzięki zastosowaniu rozwiązania do syntezy mowy możemy z robotem porozmawiać na przykład… przez telefon. Technologia syntezatora pochodzi od polskiej firmy Ivona Software – wykupionej przez Amazon, który używa tego samego rozwiązania w produkcie Amazon Alexa. Jest to w tej chwili jedno z nielicznych rozwiązań oferujących zaawansowaną syntezę mowy w języku polskim, która pozwala na przeprowadzenie płynnej rozmowy opartej na zaprojektowanych dynamicznych scenariuszach dialogowych.

Inteligentna rozmowa

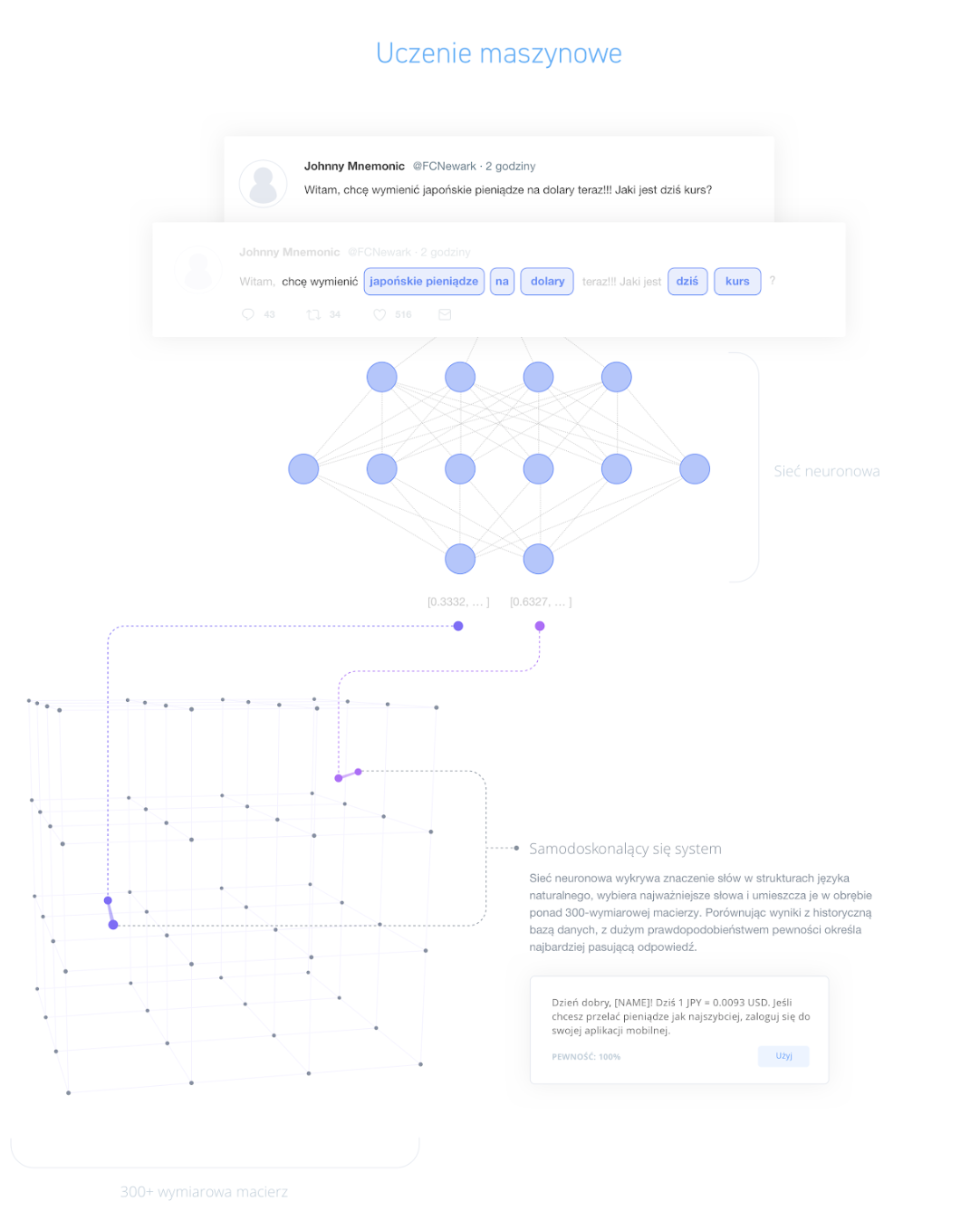

Platforma SentiOne React AI, zawiera rozbudowany silnik przetwarzania języka naturalnego NLU/NLP, który w oparciu o uczenie maszynowe bazujące na korpusach i strukturach językowych, umożliwia rozpoznawanie intencji wypowiedzi.

Mówiąc prościej: nasz system oparty na sztucznej inteligencji (AI – Artificial Intelligence), bazuje na miliardach publicznych wypowiedzi internautów, które są dostępne w bazie pochodzącej z głównego obszaru naszego biznesu – monitoringu internetu.

Dzięki takiemu połączeniu możemy nie tylko dopilnować, aby system uczył się samodzielnie, ale także – dla jeszcze lepszego zrozumienia intencji – zawęzić kompetencje bota do wybranego obszaru. I tak, na potrzeby obsługi klienta w bankowości, z ponad 23 miliardów wypowiedzi dostępnych w naszej bazie, wyekstrahowaliśmy 7 milionów dotyczących bankowości, a nasz bot nauczył się interpretować swobodne wypowiedzi ludzi i odpowiadać w naturalny dla wybranej stylistyki sposób.

Oto przykład:

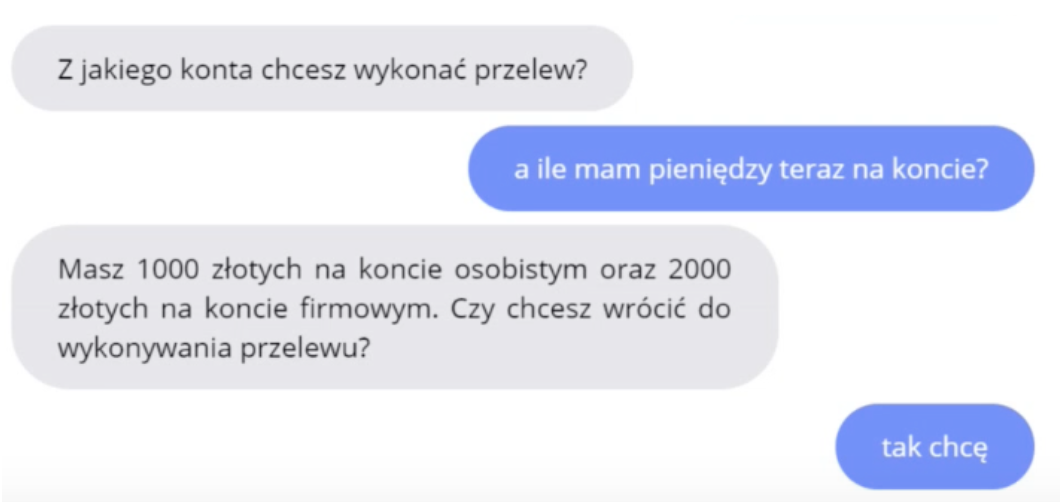

Jak widać na filmie, bot nie tylko bezbłędnie wykonuje polecenia, ale także nie gubi wątków w dyskusji.

Świadczyć może o tym fragment:

Odpowiadając pytaniem na pytanie, nie zbijamy z tropu sztucznej inteligencji – rozpoznaje ona intencję powiązaną z głównym wątkiem (pytanie o stan konta w celu decyzji, z którego z nich należy przelać środki). Odpowiada na nie, zapamiętując całą ścieżkę rozmowy i proponując powrót do omawianego tematu.

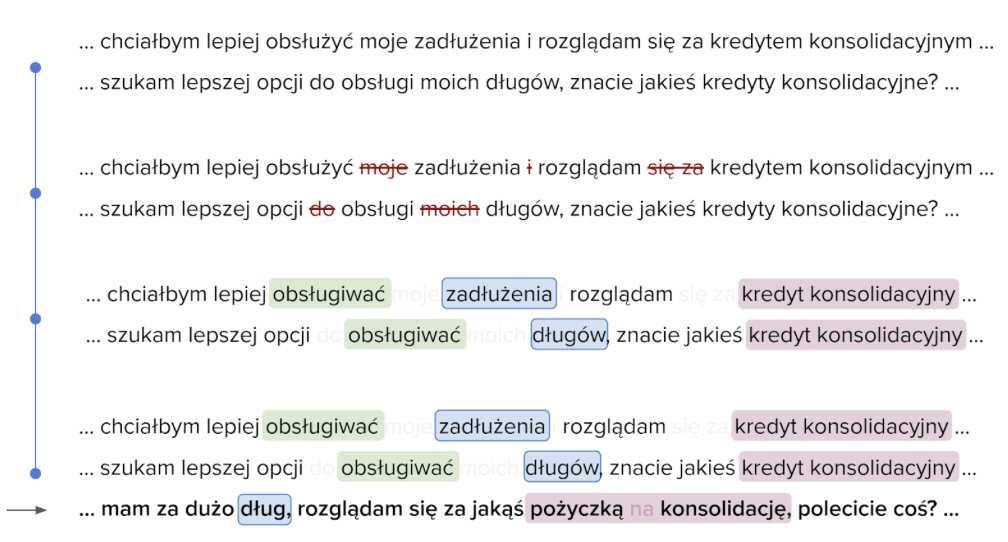

Jak to działa rozumienie tekstu?

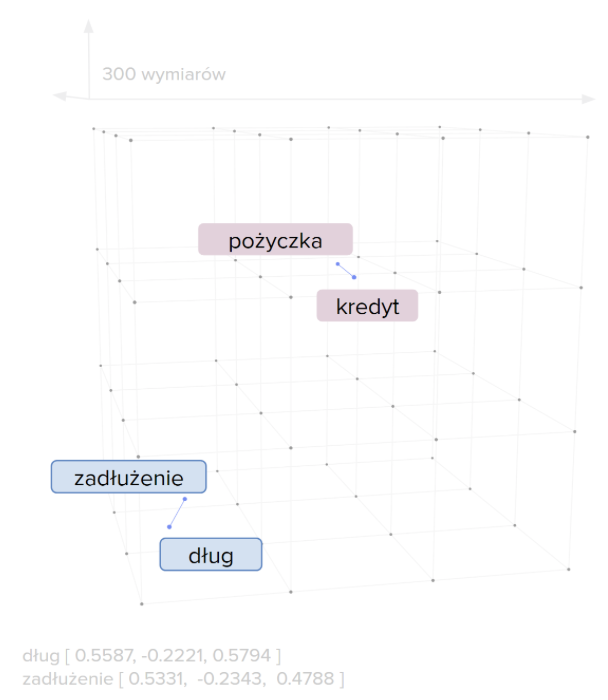

Efektem działania generatora modelu języka jest przestrzeń o 300 wymiarach. Ich liczba może być modyfikowana w zależności od dziedziny, która umiejscawia wszystkie słowa w tej przestrzeni w zależności od podobieństwa semantycznego. Dzięki ogromnej ilości danych wejściowych możliwe jest wygenerowanie modelu również z pominięciem lematyzacji (sprowadzanie słów do formy pierwotnej bez odmiany). Model może być cyklicznie odświeżany, aby uwzględnił nowe słowa pojawiające się w języku potocznym.

Jak działa rozpoznawanie intencji?

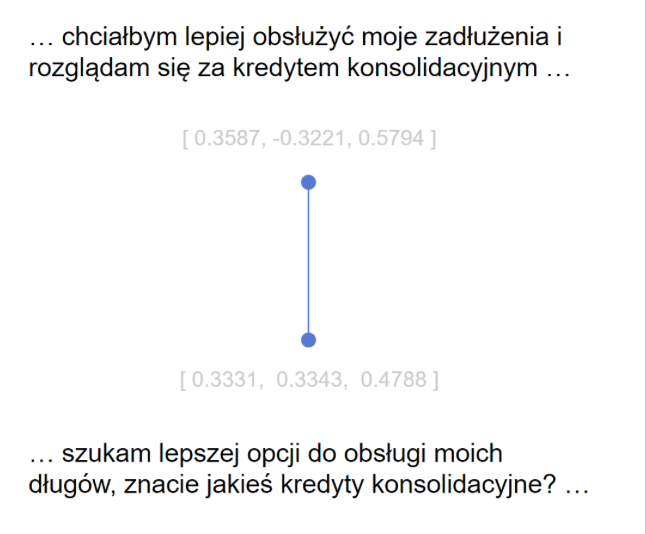

Na podstawie zbioru słów tworzony jest model semantyczny zdań w analogicznej przestrzeni o 300 wymiarach, który umożliwia rozpoznawanie podobieństwa intencji pomiędzy zdaniami używającymi z pozoru zupełnie innych słów.

W zależności od dostosowania modelu do problematyki klienta, możliwe jest zastosowanie bądź nie, narzędzi językowych w celu poprawy skuteczności rozwiązania. Mogą one usuwać często powtarzające się słowa o niskiej wadze znaczeniowej, sprowadzać słowa do tematu, dokonywać autokorekty literówek itp.

Przykład:

Nauka modelu

Moduł rozpoznawania intencji uczony jest w oparciu o dane tekstowe wypowiedzi. Mogą one zostać stworzone manualnie w przypadku braku danych lub oparte o wcześniejsze transkrypcje nagrań i wypowiedzi z chatów. Moduł rozpoznawania podczas nauki automatycznie segmentuje wypowiedzi ze zbioru treningowego w określoną liczbę grup.

Każda grupa zawiera wypowiedzi podobne do siebie semantycznie, tzn. takie, w których wyrażona jest ta sama intencja. Następnie powinna nastąpić weryfikacja ręczna – przez analityka, który może połączyć ze sobą mniejsze grupy wypowiedzi wyrażające tę samą intencję w większe grupy. Osoba analizująca temat powinna także nazwać wszystkie grupy i zweryfikować oznaczenia intencji dla wszystkich wypowiedzi w zbiorze treningowym. Na tej podstawie tworzone są umiejscowione w przestrzeni 300-wymiarowej punkty odniesienia.

Gdy pojawia się nowe zapytanie, jest ono zamieniane na formę wektorową w wymienionych 300 wymiarach, a następnie wyszukiwany jest najbliższy semantycznie punkt odniesienia. Intencja punktu odniesienia jest intencją analizowanego zapytania, a odległość w tej przestrzeni stanowi poziom ufności semantycznego dopasowania. Dzięki temu możliwe jest rozpoznanie, że wypowiedź jest nieznana w przypadku głosowego przekierowania w IVR lub w przypadku dialogu wykrycie, iż odpowiedź użytkownika nie jest zgodna ze scenariuszem, po czym może nastąpić przełączenie do konsultanta.

Rozmowa głosowa

Interakcja rozpoczyna się poprzez komunikat ze strony systemu. Użytkownik może odpowiedzieć za pomocą głosu, wiadomością lub korzystając z interaktywnego formularza. W pierwszym przypadku treść dźwiękowa jest przesyłana do modułu automatycznego rozpoznawania mowy (ASR), gdzie zostaje poddana automatycznej transkrypcji w celu umieszczenia na wspólnej ścieżce w wyżej omawianej macierzy. Wszystko to dzieje się oczywiście w czasie rzeczywistym.

W tym miejscu następuje wielopoziomowa analiza wypowiedzi, która dokonuje wieloetapowej ekstrakcji informacji, wykorzystując sieci neuronowe i tworzy wielowymiarową reprezentację wektorową wszystkich aspektów, takich jak intencja, przekazywane informacje, nastawienie czy styl wypowiedzi użytkownika. Dokładnie jak z wypowiedziami tekstowymi.

Interpretacja wypowiedzi jest przekazywana do Zarządcy Dialogu, który na jej podstawie, w oparciu o historię interakcji z użytkownikiem, wybiera optymalną ścieżkę rozmowy. W przypadku konieczności autoryzacji, w zależności od platformy, może odbywać się na rozmaite sposoby.

Przyszłość jest dziś

Automatyzacja zdecydowanie dotyczy wszystkich sfer naszego życia. Cyfrowa rewolucja dzieje się na naszych oczach. Roboty już usprawniają i optymalizują kontakt z klientem w pierwszej linii (zwłaszcza w przypadku powtarzalnych, rutynowych procesów) i czas pracy zespołów obsługi klienta, wspierają codzienne obowiązki, przyspieszają procesy i rozwiązują problemy.

Bogaci w doświadczenia związane z monitorowaniem internetu, do naszej oferty wprowadzamy nowe usługi, które dają fantastyczne możliwości naszym klientom.